潇湘晨报 2024-10-19 16:16:36

近日,有消息称字节跳动发生大模型训练被实习生“投毒”事件。

据悉,该事件发生在字节跳动商业化团队,因实习生田某某对团队资源分配不满,利用HF(huggingface)的漏洞,通过共享模型注入破坏代码,导致团队模型训练成果受损。消息称此次遭到入侵的代码已注入8000多张卡,损失或达千万美元。

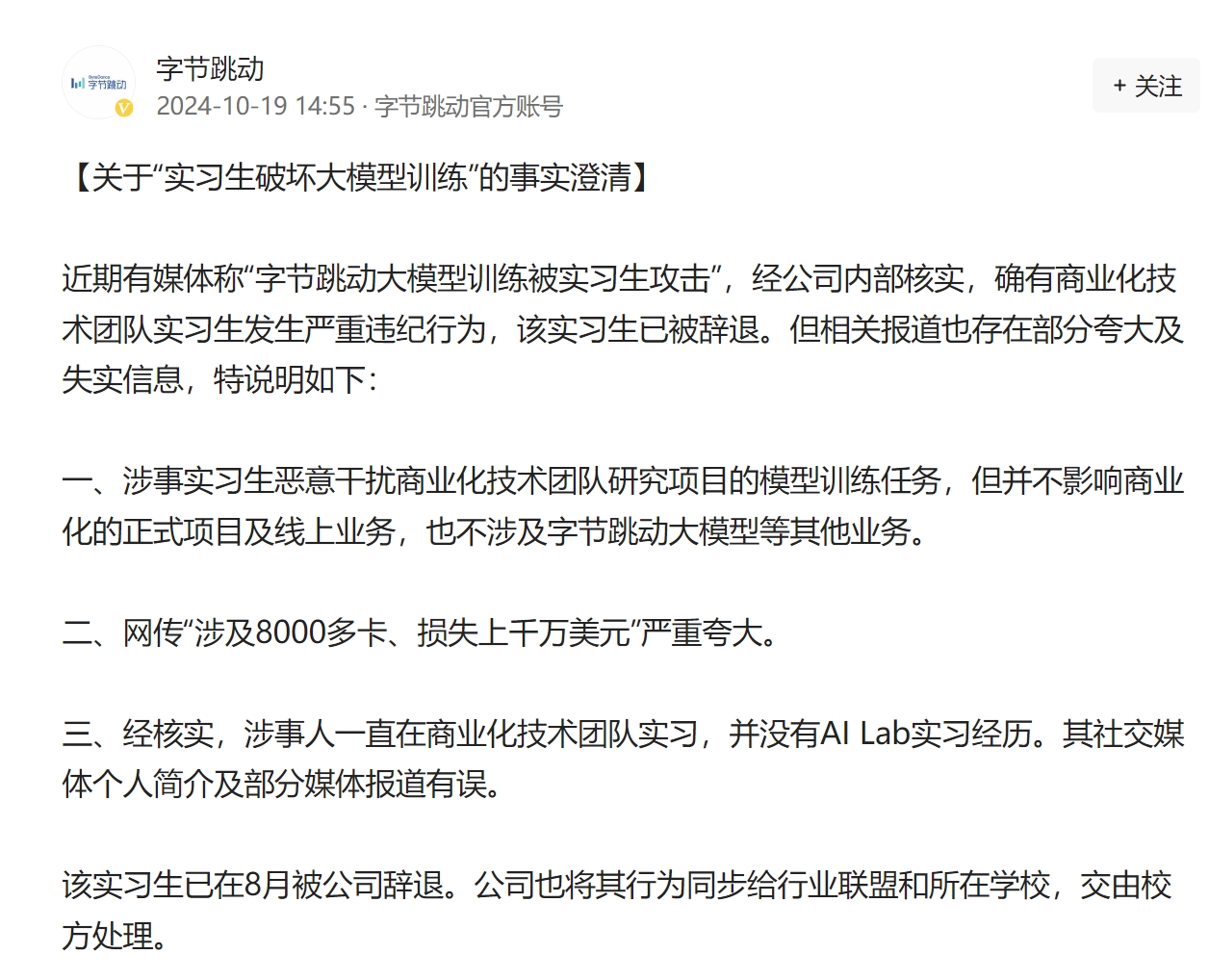

10月19日下午,字节跳动官方澄清回应称, 近期有媒体称“字节跳动大模型训练被实习生攻击”,经公司内部核实,确有商业化技术团队实习生发生严重违纪行为,该实习生已被辞退。

字节跳动表示, 相关报道也存在部分夸大及失实信息,涉事实习生恶意干扰商业化技术团队研究项目的模型训练任务,但并不影响商业化的正式项目及线上业务,也不涉及字节跳动大模型等其他业务。 另外, 网传“涉及8000多卡、损失上千万美元”严重夸大。

经核实,涉事人一直在商业化技术团队实习,并没有AI Lab实习经历。其社交媒体个人简介及部分媒体报道有误。 据悉, 该实习生已在8月被公司辞退。公司也将其行为同步给行业联盟和所在学校,交由校方处理。

有消息人士告知,田某某系北大在读学生。

此次事件暴露出字节跳动技术训练中存在的安全管理问题,包括权限隔离、共用代码的审计等。一位行业人士对记者表示,进行权限隔离与审计利于保护公司核心数据与知识产权,防止数据泄漏,提高数据与系统的安全性。比如实时监控权限使用情况,及时发现权限滥用和异常操作;定期审计权限,检查团队成员的权限是否符合授权策略,是否存在权限滥用的情况等。但这件事也有难度,包括跨部门合作成本、经常性维护与更新的资源投入等。

最新的字节跳动大模型信息披露发生在今年10月15日,火山引擎在视频云技术大会上发布了大模型训练视频预处理方案,助力解决视频大模型训练的成本、质量和性能等方面的技术挑战。目前,该技术方案已应用于豆包视频生成模型。

责编:沙兆华

一审:张笑

二审:陈永刚

三审:文凤雏

来源:潇湘晨报

我要问

下载APP

下载APP 报料

报料 关于

关于

湘公网安备 43010502000374号

湘公网安备 43010502000374号